M.I.P.

di Martina Tartaglia , Ragnatella Giulia

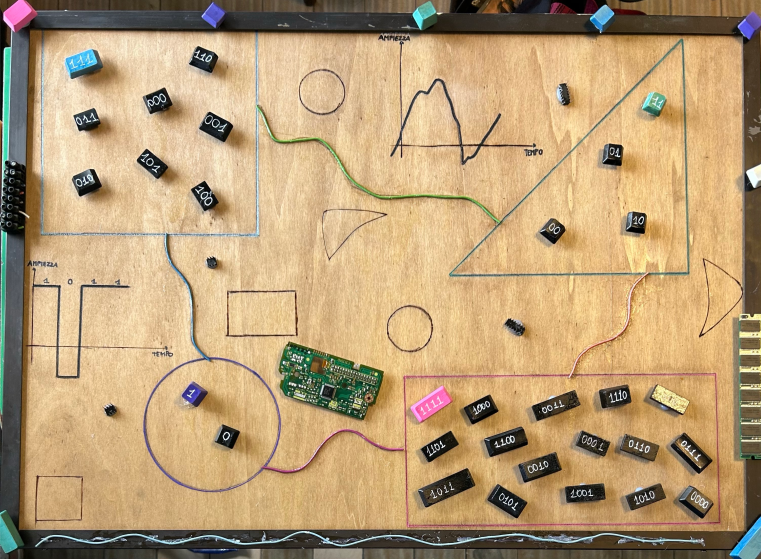

Abbiamo rappresentato degli insiemi formati da sequenze di k bit. La probabilità di

estrarre una singola sequenza è uguale a p=1/(n*disequenze). Il numero di

sequenze è pari a 2^k (disposizioni con ripetizione di due elementi in gruppi di k).

Abbiamo cercato di rappresentare in modo astratto la misura dell’entropia, misura

della quantità di informazione in un messaggio trasferito attraverso un canale, che

si misura in bit. L’informazione in bit corrisponde a log2(1/p), quindi un bit di

informazione è pari a log2(1/(1/2))=1. L’informazione è il fattore che diminuisce

l’incertezza sulla conoscenza di un evento. Le sorgenti di informazioni possono essere:

Analogiche: è un segnale il cui valore varia nel tempo in un intervallo continuo;

Digitale: è un segnale discreto che può assumere solo una successione di valori 0

e 1. Nella realizzazione abbiamo usato: pezzi di tastiere, compensato di legno inciso

con un pantografo, pennarelli indelebili e pirografo, squadre, vernice colorata.

Docenti: Giuseppina Giacomobono

Scuola: IIS “E. Mattei” Vasto – L'Aquila

In mostra nella tappa:

- L’Aquila (2023-2024)